iPhone 7 Plus 的雙鏡頭除了望遠鏡應用之外,在發表會上的另一大重點「人像散景」模式卻一直無法使用。雖說從 iOS 10.1 Beta 開始就已能使用這功能(所以我之前有發粉絲團),但對於大多數使用者來說,Beta 版系統終究不是人人會安裝的玩意,因此人像散景到底有多強,我想真正體驗過的人還是不多。

不過今天 iOS 10.1 終於正式開放更新囉!我們就來看看人像散景模式到底有何神奇之處吧!

iPhone 7 Plus 的人像散景模式被放在相機內建功能裡,滑動相機功能到「人像」就能開啟。

人像模式是利用長焦鏡頭來拍攝,因此無法拍得很廣角。不過如果以單眼相機的「長焦散景比較散」的特性來說,這點也並不奇怪就是了。不過人像散景模式終究不是基於相機原生的散景而設計的,因此仍有許多辦不到的地方。

首先,散景模式不能靠被攝主體太近,反之也不能太遠,兩種極端情況都會使得散景失效,或是散景效果不好,必須特別注意。不過如果效果不好,其實 iPhone 也會利用下方的黃色小字來提示你,所以也不算難用,只有多用幾次,就能輕鬆掌握操控訣竅。

不過必須注意兩點:第一,由於是用「光圈較小的長焦鏡頭」,拍攝時相機會預設自動瘋狂拉高 ISO,因此在低光區域會出現非常大量的雜點⋯就不太好看啦!

第二個問題,就是 iPhone 7 Plus 終究不是大片幅感光元件所帶來的「真。光學散景」,而是利用雙鏡頭拍攝的相片、距離資訊,在另用機器學習的方式判斷拍攝主體的位置、背景相對距離,以模擬出單眼相機的散景效果。以目前 iPhone 7 Plus 的運算結果來說,在絕大多數的情況下都能做出非常良好的散景表現(請見上面的公車站牌、或我拿著玉米片的相片),但在面對毛絨絨主體、或是透明/半透明主體時,就很容易發生邊緣虛化散景錯誤的問題。

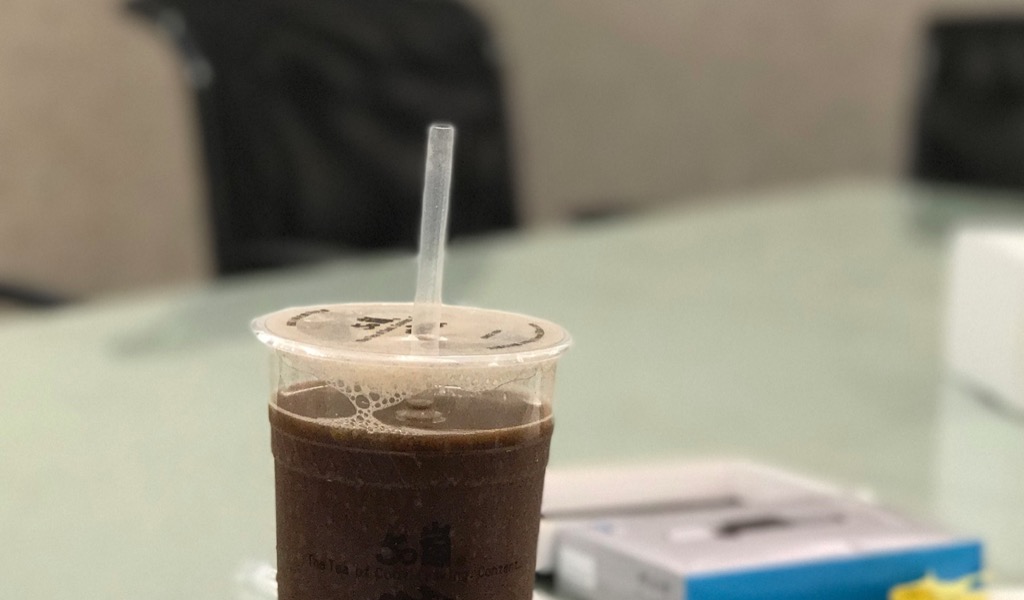

舉例來說,上圖的吸管部分就因為是白色低對比半透明物體,因此在邊緣的虛化散景就有點失敗,跟背景快要融為一體了。雖說在比較糟糕的單眼鏡頭大光圈下也是會有這種情況,但很顯然這是 iPhone 模擬出了問題。另外,在毛絨絨主體的部分,請見下圖:

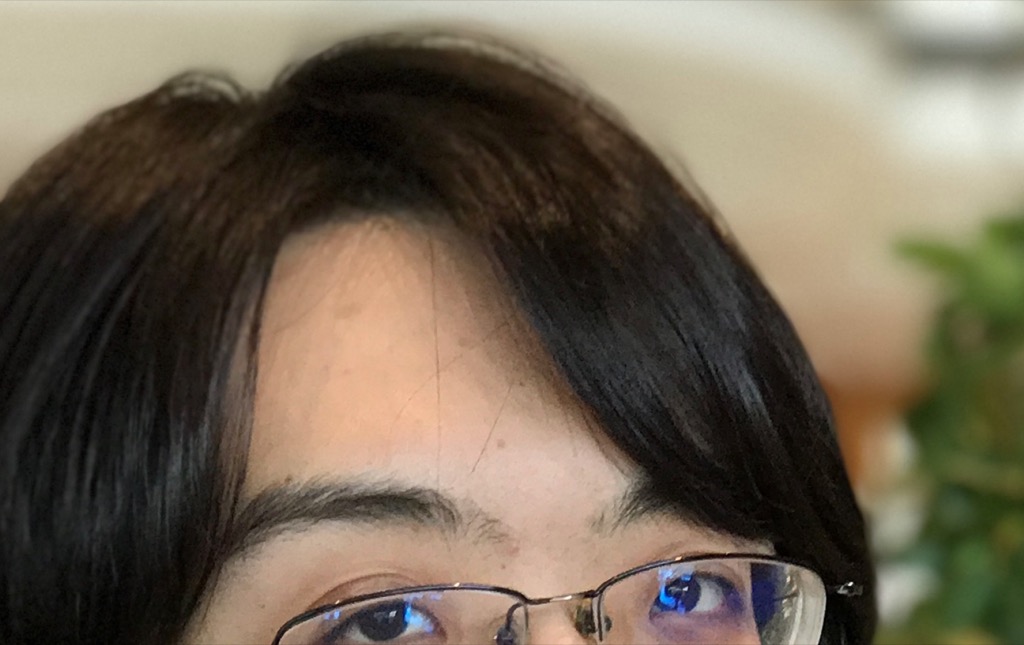

以上圖來說,姑且不論低光造成的高 ISO 雜點問題,光是我頭頂上面那些頭髮的散景就令人不悅啊!這張照片就很明顯可以看出,在頭頂頭髮那些毛毛的、或是對比不高(黑黑一片)的位置,就出現大量的散景虛化位置不一的問題,跟單眼那種依照距離不同來呈現散景的特色有很大不同。總而言之呢,以拍人或拍小物來說,整體的效果還是很不錯的(請見下圖),但如果你要求他跟單眼的效果一樣…我覺得那就太扯了,請不要因為 iPhone 要三萬多就要求太多,你買三萬多的單眼也不能拿來打電話啊!

我只能說以現在的效果我已經很滿意了,我很期待之後 iOS 改進帶來更好的效果,這從 iOS 10.1 Beta 到現在正式推出已經有很好的改進,我們可以想見未來會有更好表現。只是現在來說已經很不錯了,我們就慢慢期待囉!

請問除了蘋果還有哪一牌的手機可以做到嗎

HTㄈ啊

蘋果的相簿是不是有Bug 要刪除照片非常卡或是無法刪

我沒這問題欸…

更新完之後感覺有點耗電

我一直搞不太清楚,因為我一直都用 Beta,都很耗電